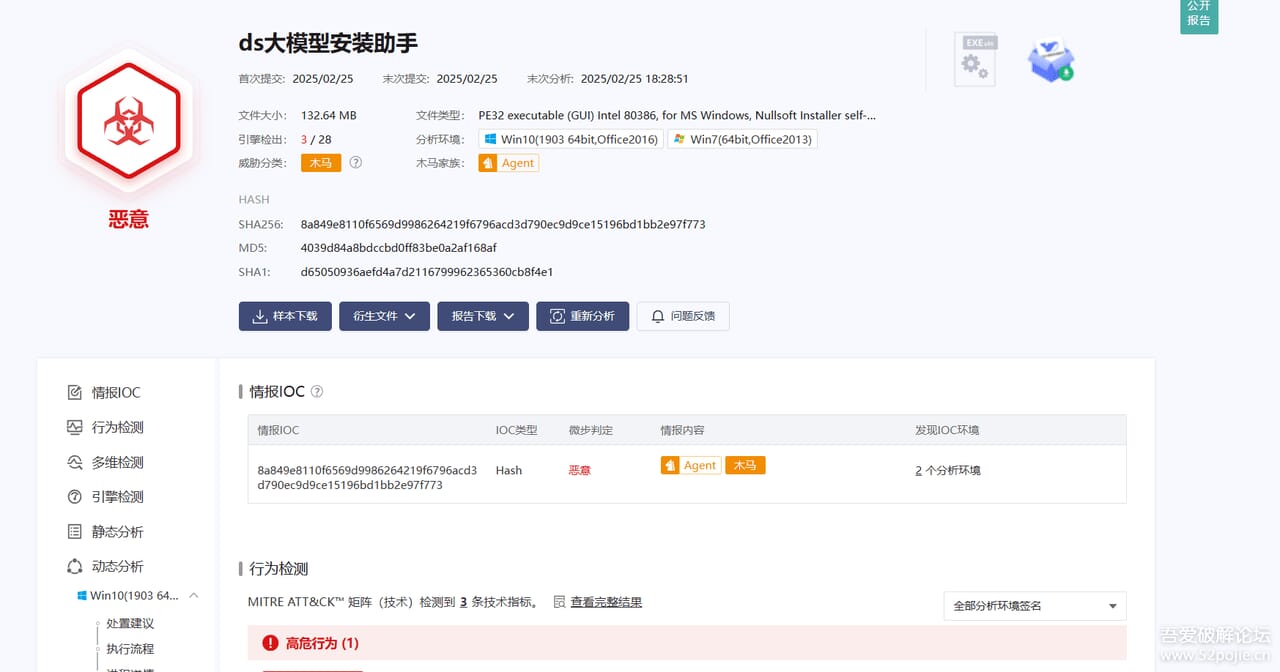

deepseek本地部署对于电脑的硬件要求极高,所以想要部署的朋友需要去考虑自己的硬件是否达标,对于大部分人不建议本地部署!

博主把最基本的环境简单罗列一下:

硬件要求

要在本地运行 DeepSeek-R1,建议具备以下硬件配置:

- GPU:NVIDIA A100 80GB / RTX 4090 / H100(推荐 24GB+ 显存)

- CPU:至少 8 核心

- 内存:至少 64GB(推荐 128GB 以上)

- 硬盘:至少 200GB 空间(建议使用 NVMe SSD)

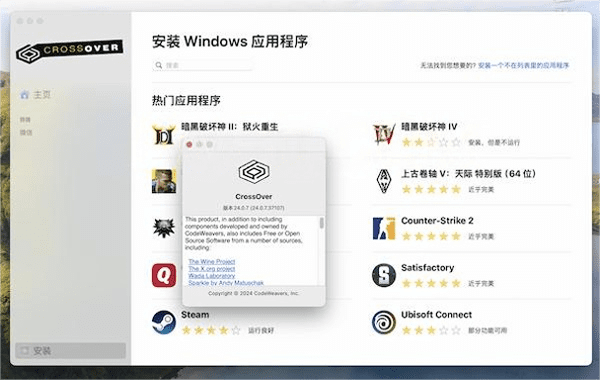

- 系统:Ubuntu 20.04+ / windows 10+ / macOS(仅限 M 系列芯片)

那么对于的 软件要求:

- CUDA 11.8+(适用于 NVIDIA GPU)

- cuDNN 8+

- Python 3.10+

- PyTorch 2.0+

- Git

- pip 23+

- Hugging Face Transformers

具体步骤:

下载Ollama,这个软件是管理和运行所有大模型的平台

下载地址:http://ollama.com

下载好以后点模型,

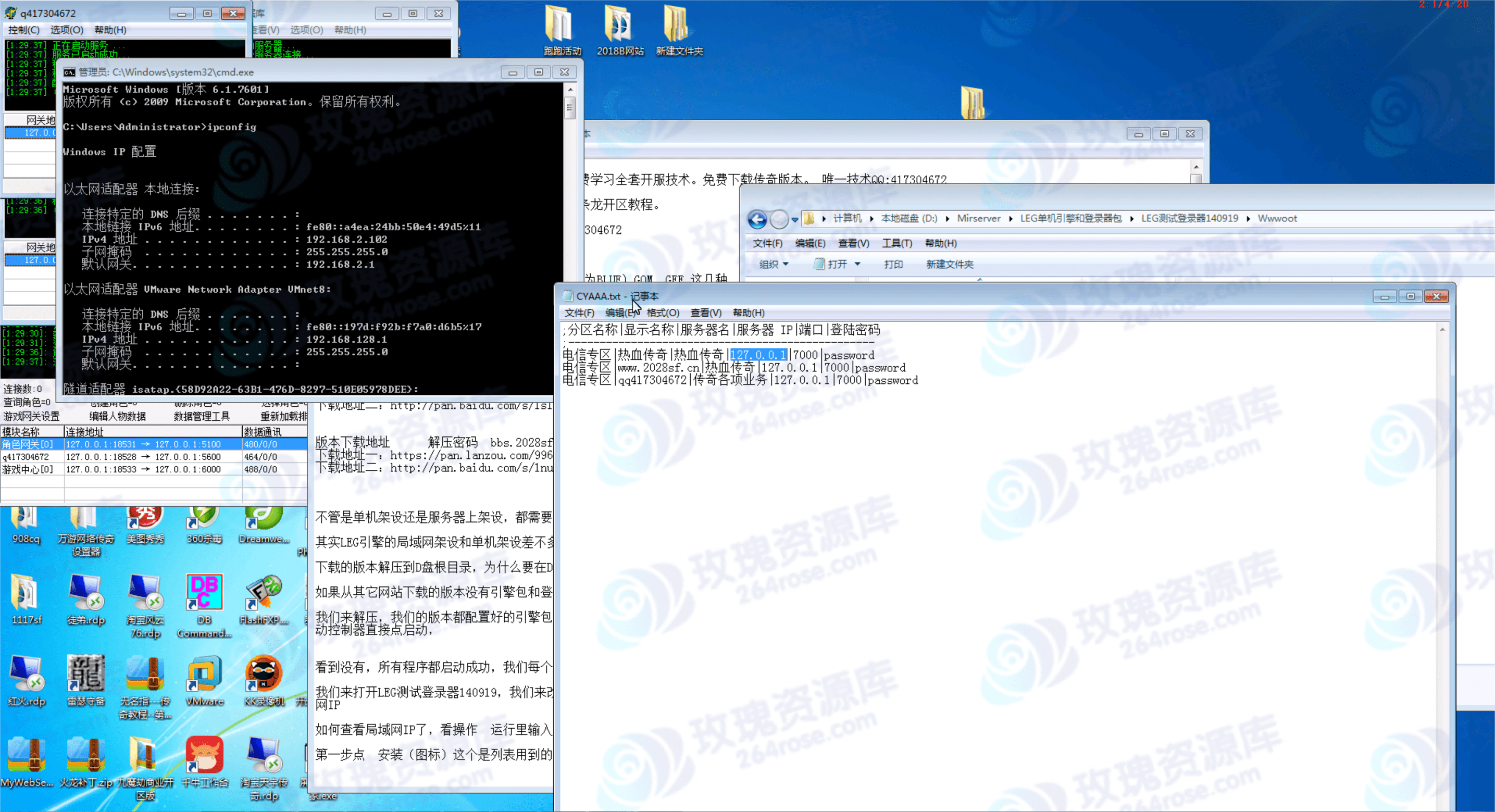

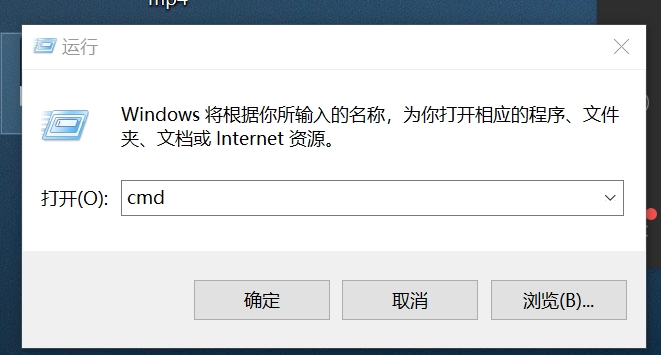

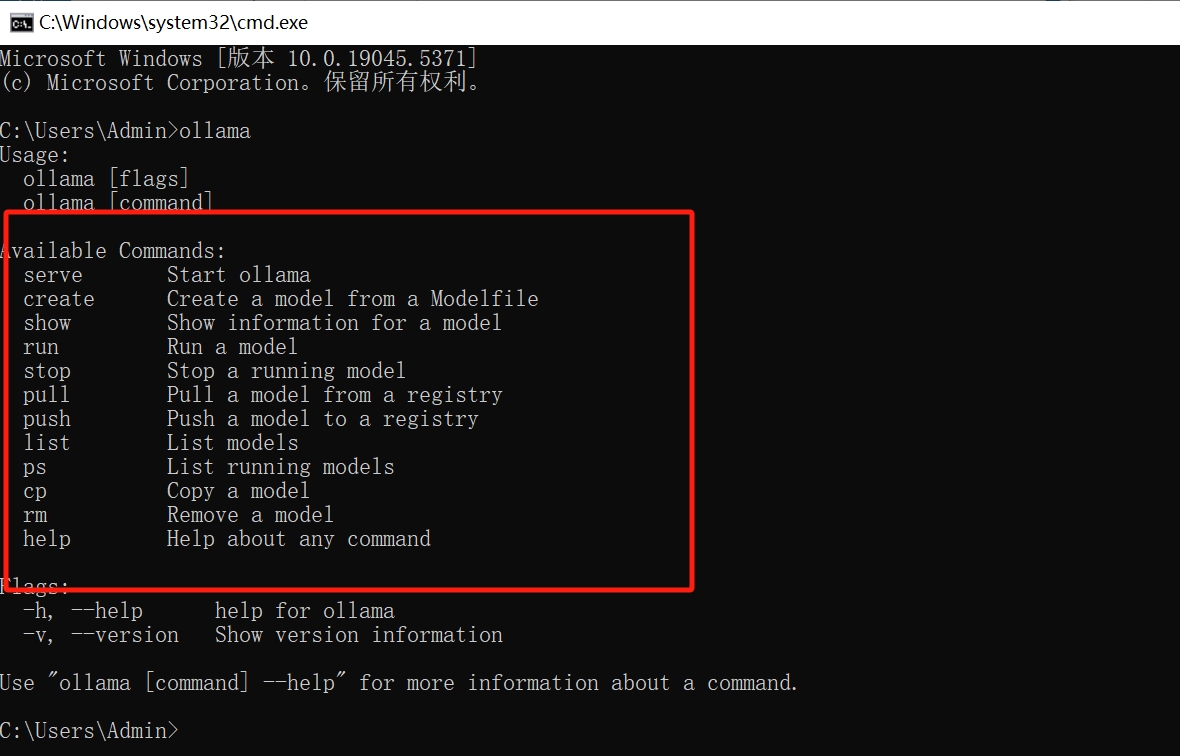

在本地电脑中输入:W+R

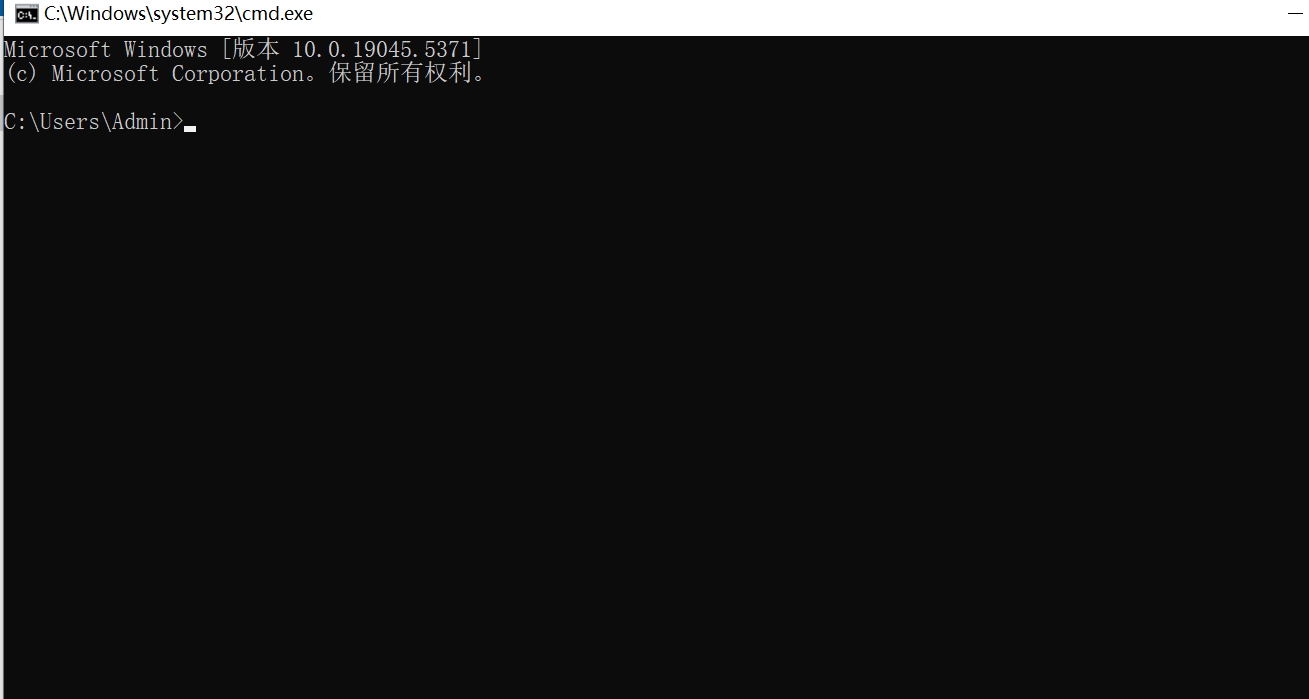

输入:ollama

输入:ollama

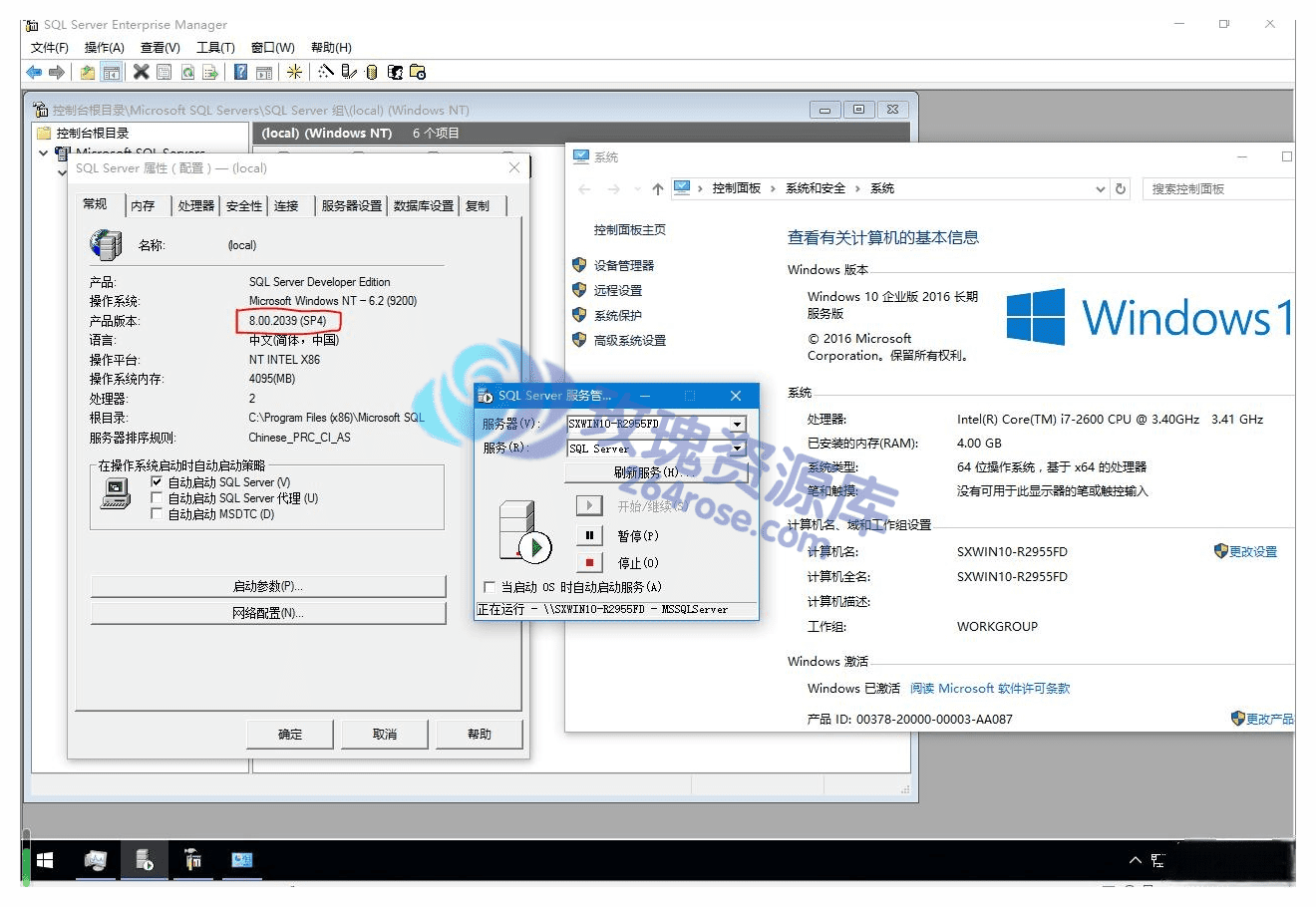

出现红框中的内容说明已经下载完成

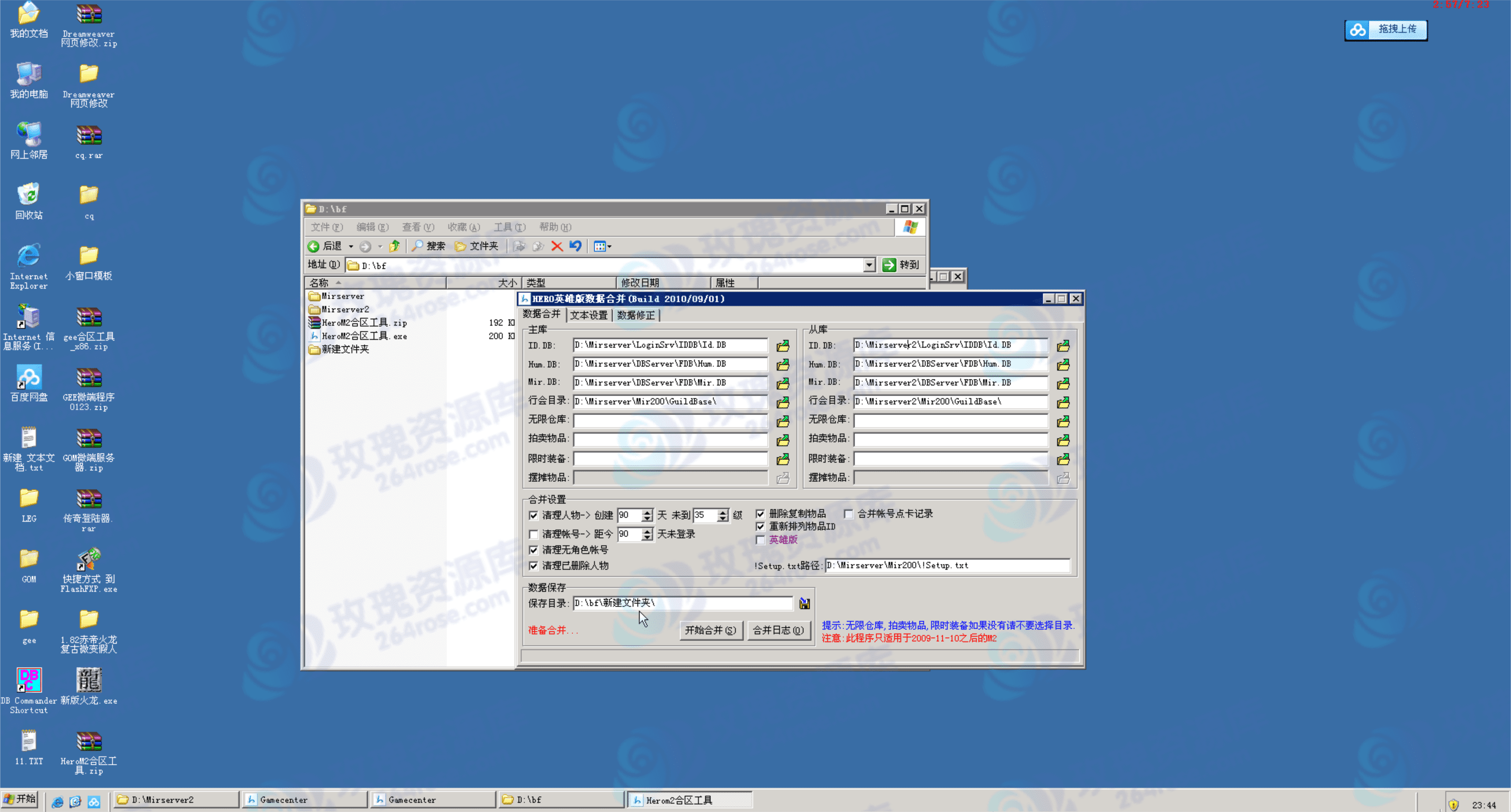

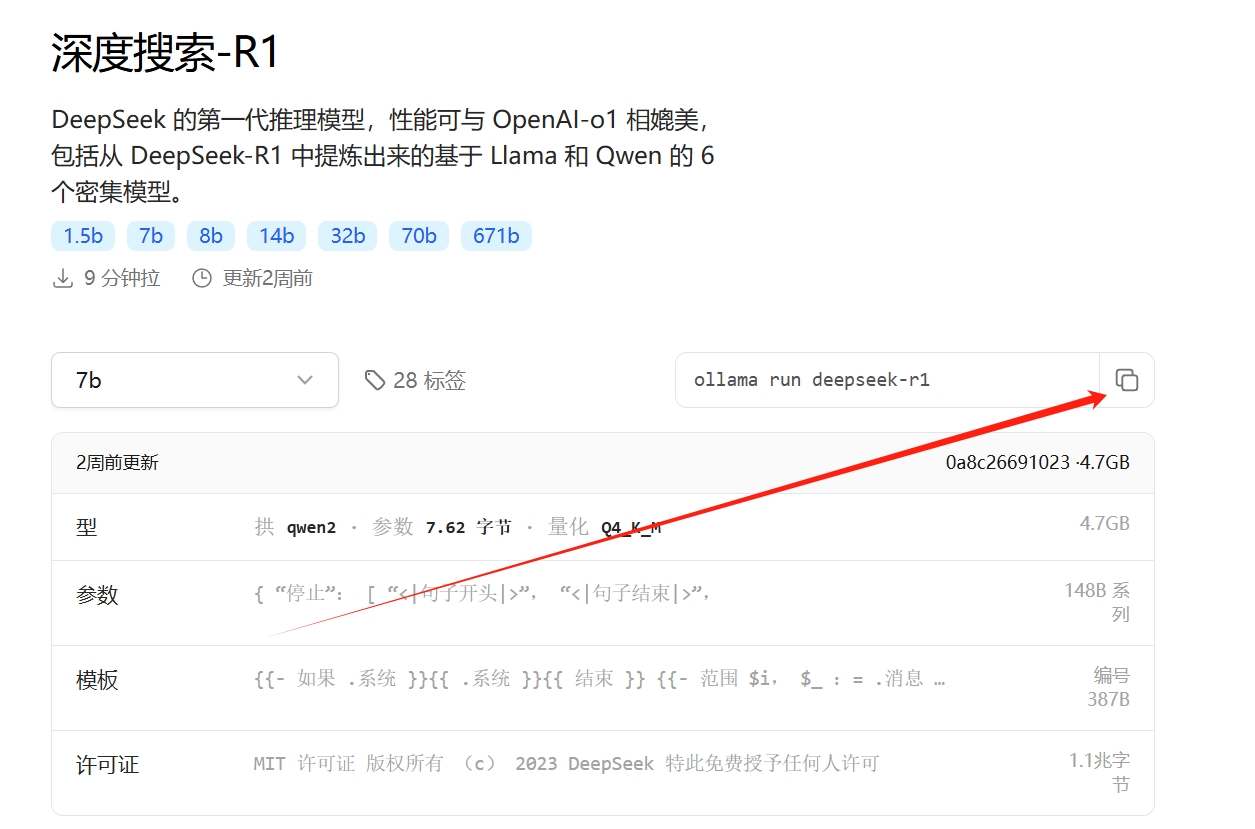

现在我们要安装搭建我们的数据库了:

现在我们要安装搭建我们的数据库了:

复制这个地址,复制到下面图示位置:

复制这个地址,复制到下面图示位置:

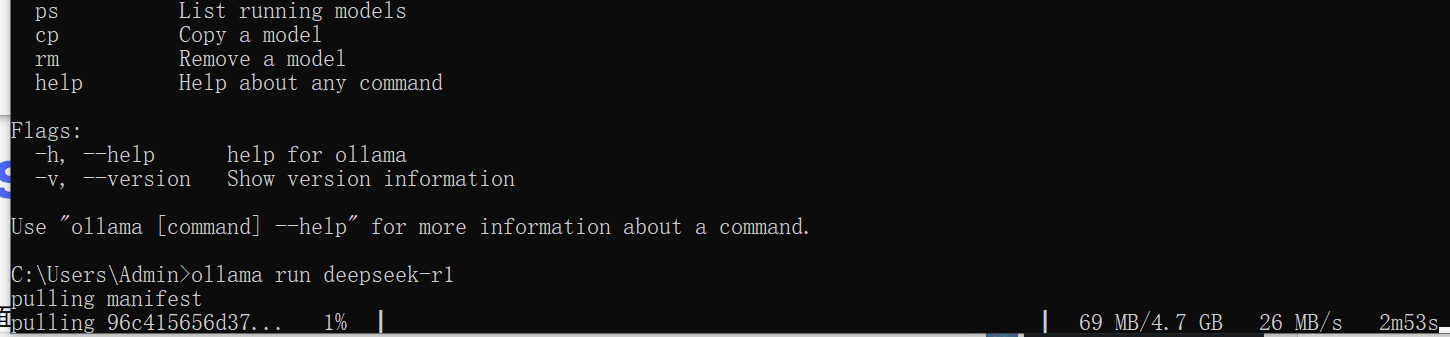

点击回车开始下载

点击回车开始下载

2. 安装环境

2.1 安装 GPU 依赖

如果你的电脑配备了 NVIDIA GPU,请安装 CUDA 和 cuDNN:

# 更新软件包列表

sudo apt update && sudo apt upgrade -y

# 安装 NVIDIA 驱动

sudo apt install -y nvidia-driver-535

# 检查显卡驱动是否正确安装

nvidia-smi

如果 nvidia-smi 正常输出,则说明驱动安装成功。

安装 CUDA 和 cuDNN

如果 nvcc --version 能正确输出 CUDA 版本,则说明安装成功。

安装 cuDNN

# 下载 CUDA 11.8 wget https://developer.download.nvidia.com/compute/cuda/11.8.0/local_installers/cuda_11.8.0_520.61.05_linux.run # 安装 CUDA sudo sh cuda_11.8.0_520.61.05_linux.run # 设置环境变量 echo 'export PATH=/usr/local/cuda-11.8/bin:$PATH' >> ~/.bashrc echo 'export LD_LIBRARY_PATH=/usr/local/cuda-11.8/lib64:$LD_LIBRARY_PATH' >> ~/.bashrc source ~/.bashrc # 验证 CUDA 版本 nvcc --version

2.2 安装 Python 依赖

3. 下载 DeepSeek-R1 模型(这点前面已经详细讲解)

DeepSeek-R1 模型可从 Hugging Face 获取。

3.1 安装 Git LFS

3.2 克隆 DeepSeek-R1 模型

git clone https://huggingface.co/deepseek-ai/deepseek-moe-16b cd deepseek-moe-16b

如果你不想使用 git lfs,可以手动下载:

4. 运行 DeepSeek-R1

4.1 加载模型

在 Python 环境中运行以下代码:

4.2 运行 Web API

如果想要通过 API 调用模型,可以使用 FastAPI:

创建 app.py:

运行 API:

然后可以通过 POST 请求访问:

5. 其他优化

- 使用 FlashAttention 提高推理速度:

- 使用

torch.compile()进行优化: - 多 GPU 运行(使用 DeepSpeed):

启动时:

总结

至此,你已经完成了 DeepSeek-R1 的本地部署,包括:

- 环境配置(安装 CUDA、cuDNN、Python、PyTorch)

- 下载模型(Hugging Face)

- 运行推理(Python 脚本和 API 服务器)

- 性能优化(FlashAttention、DeepSpeed)

好的,本节到此结束

![[源码分享] 创胜系列定制版本嘉年华房卡源代码【开发引擎Cocos Creator2.4.3】-](https://www.264rose.com/wp-content/uploads/2024/10/c4ca4238a0b9238-10.jpg)